Muajin e shkuar, AlphaGo, një program kompjuterik i projektuar veçanërisht për të luajtur lojën Go, shkaktoi shokim te admiruesit kur mundi Lee Sidol, një nga lojtarët profesionistë më të rëndësishëm në botë, duke fituar turneun me pesë lojë me një rezultat 4-1.

Përse, mund të pyesni ju, kjo përbën lajm?

Njëzet vite kanë kaluar që kur kompjuteri IBM Deep Blue mundi në shah kampionin Garry Kasparov dhe ne të gjithë e dimë se kompjuterët janë përmirësuar që atëherë. Por, Deep Blue fitoi përmes fuqisë absolute në informatikë, duke përdorur aftësinë për përllogaritje të rezultateve në një nivel më të thellë nga sa mundej kampioni. Go luhet në një dërrasë më të madhe (19 me 19 katrorë, krahasuar me 8×8 të shahut) dhe ka më shumë mundësi lëvizjesh sesa ka atome në univers, ndaj fuqia kompjuterike vetëm nuk mund të mundte një njeri me sens të fortë intuitiv të lëvizjeve më të mira.

Në fakt, AlphaGo u projektua për të fituar duke luajtur një numër të madh lojërash kundër programeve të tjera dhe duke përshtatur strategji që dolën të suksesshme. Ju mund të thoni se AlphaGo evoluoi për të qenë lojtari më i mirë i GO në botë, duke arritur në vetëm dy vite atë që përzgjedhja natyrore mori miliona vite për të arritur.

Eric Schmidt, kryetar ekzekutiv i kompanisë mëmë të AlphaGo, Google, është entuziast rreth asaj që inteligjenca artificiale (AI) nënkupton për njerëzimin. Duke folur përpara ndeshjes mes Lee dhe AlphaGo ai tha se njerëzimi do të jetë fitimtar, pavarësisht rezultatit, sepse përparimet në AI do ta bëjnë çdo njeri më të zgjuar, më të aftë dhe “qenie njerëzore më të mirë”.

Kështu do të jetë? Rreth të njëjtës kohë me triumfin e AlphaGo, “chatbot”-i i Microsoft – softueri i quajtur Taylor u projektua për t’iu përgjigjur mesazheve nga njerëz të moshës 18 deri në 24 – po pësonte një eksperiencë ndëshkimi. “Tay”, siç e quajti ajo veten, supozohej të mund të mësonte nga mesazhet që mori dhe gradualisht të përmirësonte aftësinë për të pasur biseda të sinkronizuara. Fatkeqësisht, brenda 24 orëve, njerëzit po i mësonin Tay-t mesazhe raciste dhe seksiste. Kur ajo filloi të thoshte gjëra pozitive rreth Hitlerit, Microsoft e fiku dhe fshiu mesazhet e saj fyese.

Nuk e di nëse njerëzit e kthyen Tay-n në një raciste ishin edhe vetë të tillë apo thjesht menduan se do të ishte argëtuese të prishnin lodrën e re të Microsoft. Sidoqoftë, ballafaqimi i fitores së AlphaGo dhe mundjes së Taylor shërben si një paralajmërim. Është një gjë të lësh të lirë AI në kontekstin e një loje me rregulla të caktuara dhe një synim të qartë; ësht diçka krejt tjetër të lihet i lirë AI në botën reale, ku paparashikueshmëria e mjedisit mund të zbulojë një gabim në softuer që mund të ketë pasoja shkatërrimtare.

Nick Bostrom, drejtor i Institutit e Ardhmja e Njerëzimit, argumenton në librin e tij Superinteligjenca se nuk do të jetë gjithnjë aq e lehtë të fiket një makinë inteligjente sa u fik Tay. Ai e përcakton superinteligjencën si një intelekt që është “më i zgjuar sesa truri më i mirë njerëzor në praktikisht çdo fushë, përfshirë krijimtarinë shkencore, diturinë në përgjithësi dhe aftësi sociale”. Një sistem i tillë mund t’i kalojë aftësitë tona për ta fikur.

Disa dyshojnë se superinteligjenca do të arrihet ndonjëherë. Bostrom, bashkë me Vincent Muller, i kërkuan ekspertëve të AI të përcaktonin sasinë e shanset që makineritë të arrinin inteligjencën e nivelit njerëzor dhe pati një shans nëntë nga dhjetë. Mesatarja vlerësonte se për një në dy shanse kishte një varietet nga 2040 në 20150 dhe 2075 për nëntë në dhjetë shanse. Shumica e ekspertëve prisnin që AI të arrinte superinteligjencën brenda 30 viteve të arritjes së inteligjencës njerëzore.

Ne nuk duhet t’i marrim këto vlerësime shumë seriozisht. Norma e përgjithshme e përgjigjes ishte vetëm 31 për qind dhe kërkuesit po punojnë te AI që të kenë një nxitje për të rritur rëndësinë e fushës së tyre duke trumbetuar potencialin për të prodhuar rezultate shumë të rëndësishme.

Perspektiva që AI të arrijë superinteligjencën mund të duket shumë e largët për t’u shqetësuar, veçanërisht për shkak të problemeve më urgjente. Por duhet argumentuar se duke filluar të mendojmë rreth mënyrës si mund të projektojmë AI të llogarisin interesat njerëzorë dhe në fakt të gjithë qenieve me ndjeshmëri (përfshirë makineritë, nëse ato janë qenie të vetëdijshme me interesat e tyre).

Me makinat pa shoferë tashmë në rrugët e Kalifornisë, nuk është shumë shpejt të pyesësh nëse mund të programojmë një makineri të sillet në mënyrë etike. Teksa makina të tilla përmirësohen, ato do të shpëtojnë jetë, sepse do të bëjnë më pak gabime se njerëzit. Ndonëherë, ato do të përballen me një zgjidhje midis jetëve. Duhet të programohen të shmangin goditjen e një fëmije që kalon rrugën edhe nëse vënë në rrezik jetën e pasagjerëve? Po devijimi për të shmangur një qen? Çfarë nëse i vetmi rrezik është dëmtimi i vetë makinës, jo pasagjerëve?

Ndoshta do të ketë leksione për t’u mësuar teksa fillojnë të tilla diskutime rreth makinave pa shoferë. Por këto makina nuk janë qenie superinteligjente. Mësimi i etikës te një makineri që është më inteligjente se ne, në një shumëllojshmëri fushash, është një detyrë më e fikshme.

Bostrom e fillon superinteligjencën me një fabul rreth harabelave që mendojnë se do të ishte më mirë të stërvitnin një buf t’i ndihmonte të krijonin foletë e tyre dhe të kujdeseshin për të vegjlit. Ndaj ata fillojnë duke gjetur vezën e një bufi. Një harabel e kundërshton këtë duke thënë se së pari duhet të gjejnë si ta zbusin bufin; por të tjerët janë të paduruar të çojnë përpara projektin. Ata do ta ndërmarrin sfidën e stërvitjes së bufit (që për shembull të mos i hajë harabelët) kur të kenë rritur me sukses njërin.

Nëse ne duam ta bëjmë një buf të mençur, jo vetëm inteligjent, le të mos bëhemi si ata harabelë të paduruar. /Project Syndicate/reporter.al/

Lufta Prigozhin - Putin

Më shumë

TikTokerja irakiane vritet brutalisht para shtëpisë së saj – pamjet rrëqethëse nga sulmi

Dalin pamje të reja që tregojnë veprimin që bëri Salah pas përfundimit të ndeshjes

Xhensila Myrtezaj rrëzohet në skenë, në nisje të performancës: Uroj të mos e keni kapur këtë

Dikur shkëlqente tek Liverpooli, tani është përjashtuar nga ekipi amator në moshën 28-vjeçare

Bie nataliteti në Kosovë, ASK dhe MPB me statistika të ndryshme për lindjet

Grushte të fuqishme dhe hedhje në tokë, turko-gjermani Cinkara e fiton luftën ndaj boksierit kosovar Armend Xhoxhaj

Investoni në të ardhmen tuaj – bli banesë në ‘Arbëri’ tani! ID-140

Shitet banesa në Fushë Kosovë në një vendodhje perfekte – 80.5m², çmimi 62,000Euro! ID-254

Ideale për zyre – në qendër të Prishtinës lëshohet banesa me qira ID-253

Bli shtëpinë e ëndrrave tuaja në Prishtinë – ZBRITJE në çmim, kapni mundësinë tani! ID-123

Krijo hapësirën tënde të biznesit – zyre me qira te 4 Llulat – 300€/muaj ID-252

Më të lexuarat

Grushte të fuqishme dhe hedhje në tokë, turko-gjermani Cinkara e fiton luftën ndaj boksierit kosovar Armend Xhoxhaj

Xhensila Myrtezaj rrëzohet në skenë, në nisje të performancës: Uroj të mos e keni kapur këtë

Njësiti special serb “Kobra” dyshohet të jetë pjesë e trajnimeve të grupeve terroriste pranë kufirit me Kosovën

Ish-legjenda e Liverpoolit tregon ‘arsyen e vetme’ që çoi tek përplasja e Salahut me Kloppin

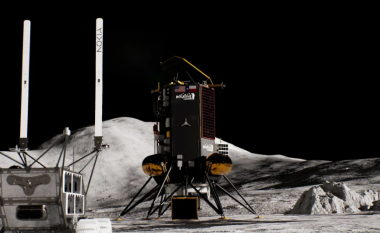

NASA dhe Nokia po dërgojnë rrjetin 4G në hapësirë - çfarë do të thotë kjo për njerëzimin?

Pamje të reja nga përplasja e Salahut me Kloppin tregojnë saktësisht se çfarë ka ndodhur

Nga Melodia Px

Nga Melodia Px

Nga Crystal Evapify

Nga Crystal Evapify

Nga Cinestar

Nga Cinestar