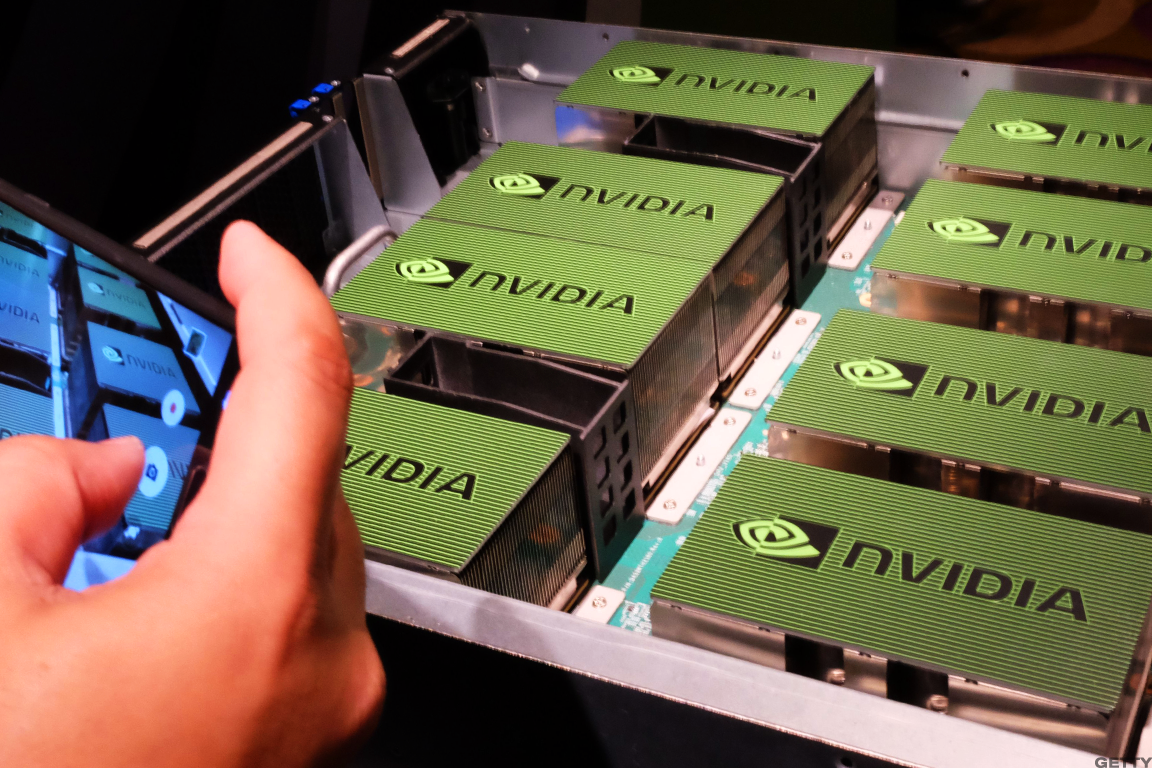

Kompania kaliforniane, Nvidia ka prezantuar një çip të ri grafik (GPU) H200, i cili është krijuar për trajnimin e modeleve të inteligjencës artificiale (AI).

GPU-ja e re është një përmirësim i çipit H100 që Open AI përdori për të trajnuar modelin më të avancuar të AI GPT-4, dhe avantazhi kryesor i H200 është 141 gigabajt memorie të avancuar “HBM3” që duhet të përsosë trajnimin, raporton CNBC.

Nvidia pretendon se H200 është pothuajse dy herë më i shpejtë se H100, por gjithashtu i përputhshëm me prapavijën, që do të thotë se kompanitë që trajnojnë modelet e AI me H100 nuk do të kenë nevojë të ndryshojnë sistemet e tyre të serverit ose softuerin për të përdorur H200.

Çipat H100 vlerësohet të kushtojnë midis 25 mijë dhe 40 mijë dollarëve secila dhe trajnimi i një sistemi AI kërkon mijëra çipa që punojnë së bashku.

Nvidia tha më parë se pret të ardhura prej 16 miliardë dollarësh në tremujorin e tretë fiskal, 170 për qind më shumë nga i njëjti tremujor në vitin 2022. /Telegrafi/

Based on the NVIDIA Hopper architecture, the NVIDIA HGX H200 features the NVIDIA H200 Tensor Core GPU with advanced memory to handle massive amounts of data for generative AI and #HPC workloads. #SC23

— NVIDIA Data Center (@NVIDIADC) November 13, 2023